ИИ – угроза для человечества на уровне с ядерной войной и пандемиями: прогнозы суперфоркастеров

Отраслевые эксперты даже пессимистичнее по поводу влияния технологии

Это объясняют тем, что развитие ИИ может косвенно увеличивать риски и ядерки, и появления новых вирусов и других угроз

ИИ уже рассматривают как потенциальную угрозу человечеству на уровне с ядерной войной и пандемиями.

Детали

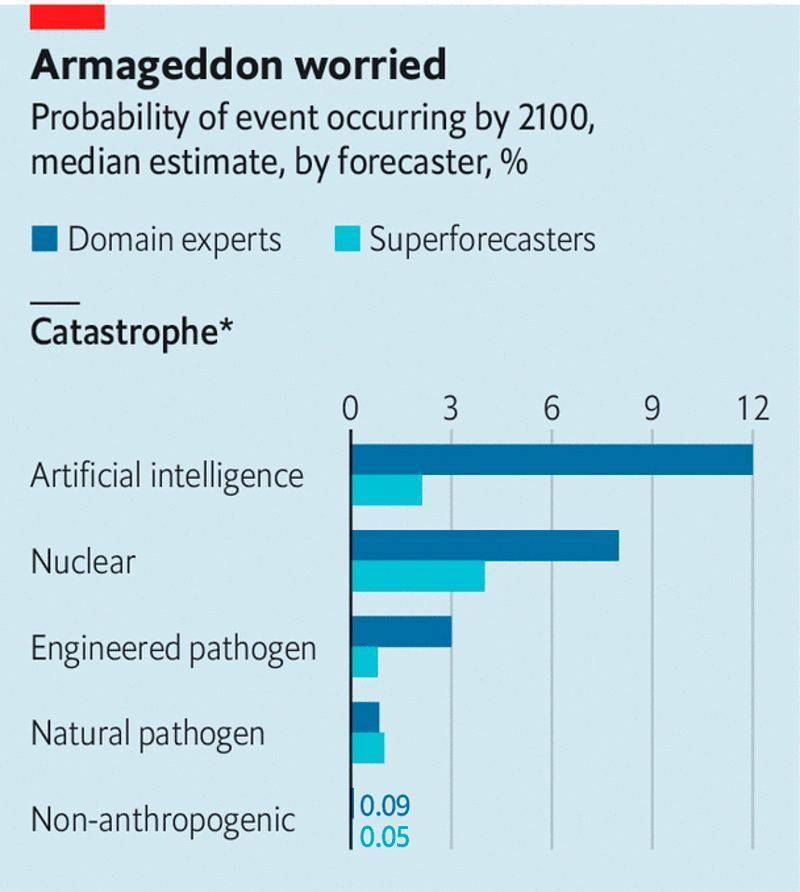

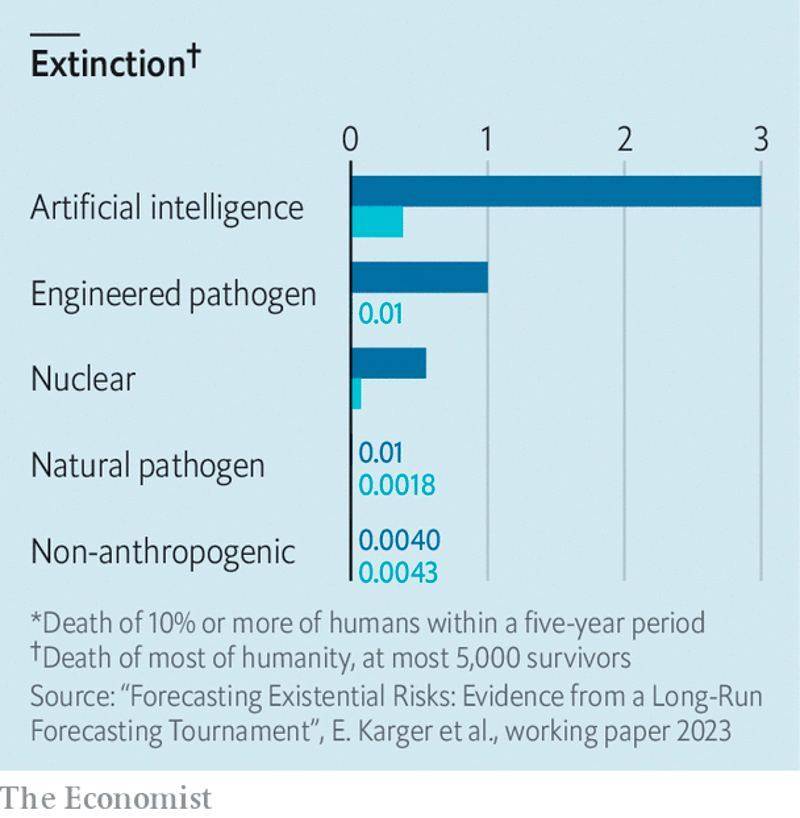

The Economist публикует результаты прогнозов суперфоркастеров и ШИ-экспертов, с какой вероятностью та или иная причина вызовет катастрофу (погибнет менее 10% населения) или исчезновение человечества (останется до 5000 человек).

Как видите на сундуке, в противостоянии ИИ vs ядерка в обеих группах больше переживают первым, пишет народный депутат Ярослав Железняк в Telegram.

Отраслевые эксперты даже пессимистичнее по поводу влияния технологии: они оценили вероятность катастрофы из-за ИИ в 12%, а вымирание в 3%. У суперфоркастеров отметки 2,1% и 0,3% соответственно.

В общем, это объясняют тем, что развитие ИИ может косвенно увеличивать риски и ядерки, и появления новых вирусов, и других угроз.

Вместе с тем опрошенные говорят, что пока мало данных для лучших прогнозов. Плюс все зависит, какие механизмы применят для противодействия роковым последствиям, и насколько ИИ будет иметь выход в физический мир. Так что пока можно переживать чуть меньше (и не читать последнюю книгу Дэна Брауна).

В ЕК будут использовать ИИ для подготовки пресс-релизов большим с количеством языков.

Не пропустите интересное!

Подписывайтесь на наши каналы и читайте новости в удобном формате!